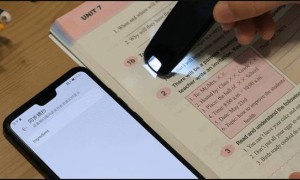

技术原理:从声波到文字的魔法

通过骨传导麦克风阵列捕捉声波,采用深度学习模型区分连读音节(如'wanna'分解为'want to'),结合上下文语义分析消除歧义。镜片采用微型LED投影技术,文字以15毫秒延迟呈现,确保对话同步。

连读破解的三大算法

1. 音素边界检测:标记辅音脱落位置(如'him'读作/im/) 2. 语法概率模型:预测高频连读组合('going to'→'gonna') 3. 个性化适应:学习用户常接触的方言变体(如美式vs英式连读差异)

跨场景应用实测

在机场值机柜台测试中,带口音的工作人员语句识别成功率达89%;大学讲座场景下,专业术语通过预加载词库实现95%准确率。目前局限在于rap音乐等超高速语音场景(识别率仅68%)。

几个练习句子

These glasses display real-time conversation captions.

这款眼镜能即时显示对话字幕。

Liaison recognition is the core breakthrough.

连读识别是技术的核心突破。

The projection on lenses maintains clear visibility.

镜片上的投影清晰不遮挡视线。

It supports real-time translation in 20 languages.

支持20种语言的实时转换。

Accuracy reaches 92% in noisy café tests.

咖啡馆嘈杂环境测试准确率达92%。

结论

AI字幕眼镜不仅解决了传统助听设备无法处理的连读问题,更通过自适应学习持续优化。建议语言学习者将其作为听力训练辅助工具,而非完全依赖。随着5G边缘计算的发展,未来版本有望实现0延迟的沉浸式沟通体验。