AI纠音核心技术解析

现代AI发音评估依赖三大技术支柱:1)声学模型通过深度神经网络分析音素特征,能识别细微的舌位偏差;2)语音识别引擎将你的发音与母语者数据库进行200+维度比对;3)韵律分析模块检测重音、连读和语调曲线。以ELSA Speak为例,其专利技术可定位到具体音标的发音缺陷,误差精确到0.1秒。

7天训练体系拆解

Day1-2:基础音标攻坚,重点突破中文母语者最易出错的/θ/、/ð/和/v/;Day3-4:单词重音模式训练,掌握500个高频词的正确重音;Day5-6:句子韵律打磨,学习连读、弱读规则;Day7:情景对话实战,AI模拟商务会议、机场值机等真实场景。每天30分钟刻意练习,配合即时可视化反馈。

文化差异对发音的影响

汉语的声调特性导致英语语调扁平化,而英语的stress-timed节奏与中文syllable-timed节奏存在本质差异。AI训练中特别加入文化对比模块,例如:中文母语者常将‘very’读成‘wery’是受方言唇齿音缺失影响;‘think’发成‘sink’源于普通话缺乏齿间音位。

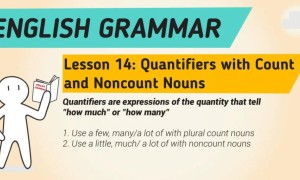

几个练习句子

Practice sliding from /a/ to /ɪ/ in 'time'

双元音/aɪ/需要滑动舌位

Place tongue between teeth for 'think'

轻辅音/θ/要舌尖抵齿

REcord (n.) vs reCORD (v.)

重音位置改变词性

'want to' becomes 'wanna'

连读时省略辅音

Your name is? ↗

疑问句末尾升调

结论

AI纠音将传统6个月才能达到的发音改善压缩到7天。关键不在于练习时长,而在于精准识别问题+高频纠正。建议选择具备音素级分析能力的工具(如推荐指数五星的ELSA),每天专注攻克1-2个发音痛点。记住:即使是BBC主播,也需要持续进行发音维护训练。